Absolument tout et n'importe quoi est annoncé supportant le ray-tracing, y compris les nouveaux téléphones.

C'est devenu un argument marketing et je suis sur que ça doit marcher sur 99% des utilisateurs qui n'ont strictement aucune idée de ce que ça peut bien être.

Le 1% restant connait la techno et sait que soit ça ne sert à rien sur l'appareil concerné, soit qu'activer cette option rendra le jeu totalement injouable.

Raytracing sur une switch2 qui aura au mieux la puissance d'une PS4 alors que même sur la PS5 c'est du RT très light

Mais ce n'est pas un mensonge, elle pourra effectivement faire du RT, si on accepte de jouer à 5 ips.

Faut prendre en compte plusieurs choses. Déjà la "puissance" faut voir ce que c'est. Le mieux pour le RT, c'est pas de la puissance brute, mais des core spécialisés (RT core).

Deuxièmement, la Switch 2 aura petit écran, donc jouer en plus faible résolution ne posera pas les mêmes problèmes que sur une télé.

Enfin, la Switch 2 supportera l'upscaling DLSS ce qui permet de diminuer encore la résolution de rendu et libérer les ressources disponibles pour autre chose.

La Switch 2 va être basée sur la génération Ampere, c'est à dire des GPU qui s'en sortait bien en DLSS et RT. L'architecture Rage 6 de la PS4 date elle d'une époque où personne ne parlait de RT ou d'upscaling par deep learning. Même à puissance équivalente ces 2 générations sont très différentes.

Globalement, à puissance équivalente à la PS4, la Switch 2 devrait être capable de gérer des moteurs plus poussés en échange d'une baisse de résolution et sera en plus épaulée par des cores spécialisés RT core et tensor core pour gérer ray tracing et DLSS.

Même la PS5 et la XBox Series X n'ont pas de RT core, ce sont les shadings units qui s'occupent du RT, ils en sont capables dans une certaine mesure mais beaucoup moins efficaces.

Dernière modification par Borh ; 25/09/2023 à 11h19.

|

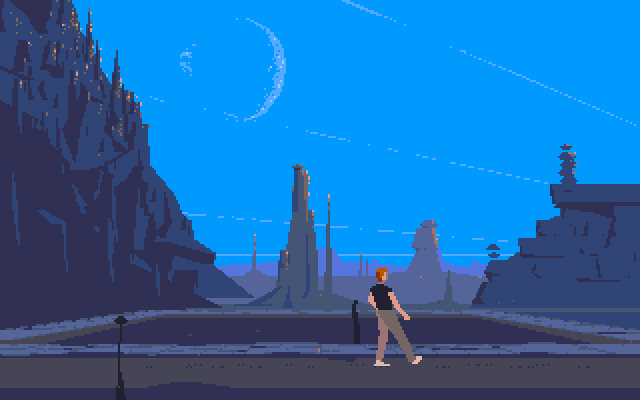

j'en ai passé des nuits blanche dessus...

j'en ai passé des nuits blanche dessus...